Multi-modality 모델이 Vision-and-Language(V+L) task를 해결하기 위해서는 visual 및 textual 입력을 동시에 받아 둘을 연결지어 이해하는 능력을 학습하는 것이 가장 중요하다. 이전의 연구들에서 제시한 모델들은 과하게 task-specific한 세팅을 사용했으며, 구조는 논문마다 차이가 심해 일반화가 잘 되지 않는다는 큰 단점이 존재했다. 논문에서 소개한 UNITER는 4개의 pre-training task를 사용하여 모델의 일반화를 향상시켰으며, 결과적으로 6개의 task에서 SOTA를 달성하게 되었다.

UNITER

UNITER의 전체적인 구조는 위와 같다. 이미지 및 텍스트 입력이 주어지며, 각각 modality를 처리하기 위한 image/text embedding을 사용하게 된다. 이후의 Transformer layer로 계산된 representation으로 pre-training task에 대한 학습을 진행한다.

- Image Embedder: Faster R-CNN으로부터 추출된 RoI를 사용하며, 7차원 벡터값인 location feature를 각 이미지 영역에 대해 인코딩 함.

- Text Embedder: 기존의 BERT와 동일한 input embedding을 사용하며, WordPiece tokenizer로 토큰화된다.

Pre-training tasks

앞서 언급했듯, UNITER은 4가지 pre-training tasks에서 학습되었고, 이로 인해 모델의 일반화를 향상시켜 다양한 downstream task에서 좋은 성능을 보일 수 있다. 또한, 본 논문에서는 이미지와 텍스트 modality를 분리하여 MLM, MRM으로 마스킹 task를 세팅하였고, 이를 conditional masking이라고 한다.

- MLM(Masked Language Modeling): BERT에서 제시된 모델링 Objective로, 여기선 텍스트 입력을 마스킹하고 복구하는 task로 정의된다.

- MRM(Masked Region Modeling): MLM과 유사하게 15%의 입력을 마스킹하며, 이미지 입력을 다루는 모델링 task이다. 같은 objective를 기반으로 3가지 변형 objective를 사용하며, Feature regression, Label classification, 그리고 Classification w/ KL-Divergence가 이에 해당된다.

- ITM(Image-Text Matching): ITS는 특별 토큰 [CLS]로 생성된 representation을 사용해 이미지와 텍스트가 매칭되는지의 여부를 예측하는 task이다.

- WRA(Word-Region Alignment): WRA는 기존의 transformer가 단어 간의 연관성을 파악하는 것과 비슷한 원리로, 단어와 이미지의 alignment를 예측하는 task이다. 이때 Optimal Transfer(OT)라는 기술이 사용되며, 이는 행렬-벡터 연산만을 사용하기 때문에 쉽게 결과를 얻을 수 있다.

Datasets

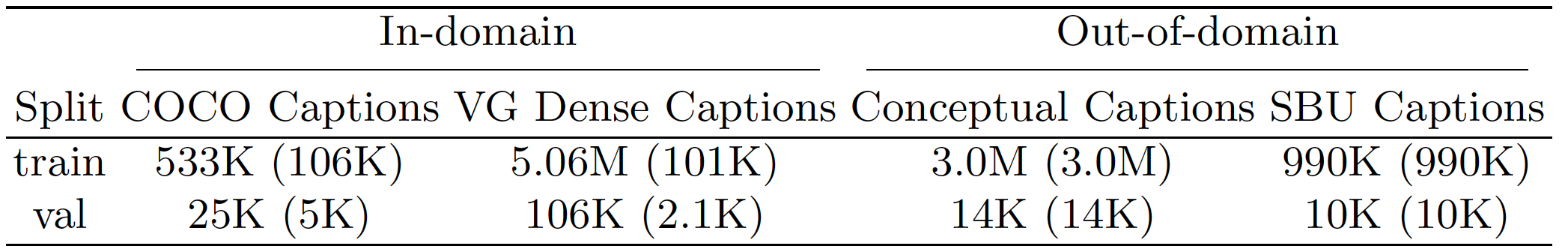

Pre-training에 사용된 데이터셋은 위와 같이 4개로 구성되어 있다. 데이터셋은 In-domain과 Out-of-domain으로 나뉘었다. In-domain에 해당되는 COCO와 Visual Genome image captioning 데이터셋은 대부분의 task가 해당 데이터셋을 기반으로 구축되었기 때문에 공정한 데이터 생성을 위해 downstream task에서 등장하는 valid/test 이미지를 삭제하는 작업을 수행했다.

Experiments

실험 과정에서 UNITER는 6개의 task에서 평가되었으며, 모델 크기는 12-layer의 UNITER-base 모델과 24-layer의 UNITER-large 두 가지 모델이 사용되었다. VQA, VCR, 그리고 NLVR task는 이미지와 질문이 주어질 때 모델은 답변을 예측한다. Visual Entailment에서는 SNLI-VE 데이터셋이 사용되었으며 이미지와 텍스트의 entailment를 예측한다. Image-Text retrieval 텍스트는 COCO와 Flickr30k 데이터셋을 사용하여 평가하며, IR(Image Retrieval)과 TR(Text Retrieval) 두 세팅에 대해 평가한다. Referring Expression task는 캡션에 해당하는 이미지 영역을 찾는 것으로 RefCOCO+ 데이터셋이 사용되었다.

각 task와 세부적인 세팅에 따른 모델 성능 결과는 위 그림과 같다. Pre-training 과정에서 사용되는 데이터셋과 task의 유무로 인한 성능 차이를 평가한 것이며, 최종적으로 WRA와 MRM을 포함한 모든 pre-training task를 사용한 모델이 가장 성능이 좋은 것을 확인할 수 있었으며, 또한 데이터셋의 유무도 성능에 큰 영향을 주는 것을 볼 수 있다.

위의 표는 다른 baseline 모델들과 성능을 비교한 표이고, 표가 너무 길어서 일부분만 가져왔다. 결과적으로 모든 task에서 UNITER 모델이 기존의 모델들과 비교하여 더 좋은 성능을 보여준다는 것이 핵심 포인트이다.

Conclusion

오늘도 새로운 멀티모달 method를 다룬 UNITER에 대해 알아보았다. 중간에 WRA와 같은 pre-training task를 이해하는데 어려움이 있었으나, 결과적으로 좋은 성능으로 이끌었던 task임을 알 수 있었다. 타임별로 정리해둔 2019년 멀티모달 논문은 UNITER를 마지막으로 전부 읽고 포스팅을 마무리했다. 아무래도 같은 해의 BERT의 등장으로 encoder transformer 기반의 논문들이 대거 등장했던 것을 알 수 있었다. NLP 분야에서도 텍스트 생성이 제한되는 BERT이기에, GPT를 사용하는 추세로 이어지며 멀티모달 논문들의 추세도 어떻게 바뀌었는지에 대한 궁금증을 가지게 된 것을 마무리로 포스팅을 마무리한다.

논문